|

| |

Comment bien choisir son écran photo ou vidéo ? -

8/10 :

À quoi sert l'accélération matérielle et quand l'activer ?

Nos ordinateurs regorgent aujourd'hui de puissance mais seule une petite partie est le plus souvent utilisée à un moment t par nos processeurs et notre carte graphique. Les fabricants de logiciels commencent à le comprendre et délèguent certains de leurs calculs aux cartes graphiques et non plus seulement au processeur. Ce processus qui consiste à confier telle partie de l'ordinateur à tel ou tel calcul afin de l’accélérer s'appelle l'accélération matérielle.

Parallèlement à cette évolution bienvenue, on observe également une amélioration de l'affichage des dégradés grâce aux fameuses tables LUT sur 10 bits. Mais de quoi parle-t-on ?

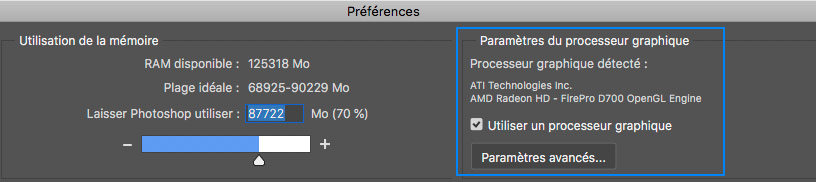

Nos chères cartes graphiques (GPU) savent aujourd'hui faire bien d'autres choses que de simplement afficher nos belles images ou nos jeux vidéos. Certaines savent en effet aujourd'hui seconder le processeur (CPU) dans certains calculs complexes grâce à diverses améliorations logicielles ou matérielles - on parle d'accélération matérielle - pour rendre les temps de traitement de nos images ou de nos vidéos toujours plus courts et permettre parfois d'accéder à des qualités d'affichage toujours améliorées grâce au codage sur 10 bits (avec un écran, un système d'exploitation et un logiciel compatibles) comme nous le verrons plus spécifiquement sur la page suivante : Affichage 10 bits  . Il est donc sage de faire le point pour savoir qui fait quoi et si vous en avez réellement besoin... . Il est donc sage de faire le point pour savoir qui fait quoi et si vous en avez réellement besoin...

|

| |

|

|

| |

L'accélération matérielle et les technologies de calculs spécifiques : CUDA, OPEN CL, OPEN GL, METAL.

Commençons par le plus important ! Vous êtes nombreux à me demander des conseils à propos de votre future carte graphique et à me demander si la carte graphique a une influence sur la qualité d'affichage des photos, des couleurs ? Et bien comme je l'ai dit page précédente : pour calculer et donc afficher nos images ou nos vidéos avec fluidité, les deux fabricants de cartes graphiques que sont NVidia et ATI n'utilisent pas les mêmes moteurs de calculs. Ils possèdent chacun leur propre savoir-faire et leur propres optimisations. Or ces optimisations et singularités ne seront pas visibles pendant l'affichage simple des images dans Photoshop car il s'agît de quelques choses d'assez "simple" à faire et surtout d'universel. Toutes les cartes graphiques du marché savent le faire sans que l'on se pose de question. Donc à quel moment le choix d'une carte graphique devient plus "stratégique" ? Commençons par le plus important ! Vous êtes nombreux à me demander des conseils à propos de votre future carte graphique et à me demander si la carte graphique a une influence sur la qualité d'affichage des photos, des couleurs ? Et bien comme je l'ai dit page précédente : pour calculer et donc afficher nos images ou nos vidéos avec fluidité, les deux fabricants de cartes graphiques que sont NVidia et ATI n'utilisent pas les mêmes moteurs de calculs. Ils possèdent chacun leur propre savoir-faire et leur propres optimisations. Or ces optimisations et singularités ne seront pas visibles pendant l'affichage simple des images dans Photoshop car il s'agît de quelques choses d'assez "simple" à faire et surtout d'universel. Toutes les cartes graphiques du marché savent le faire sans que l'on se pose de question. Donc à quel moment le choix d'une carte graphique devient plus "stratégique" ?

|

| Le choix d'une marque de cartes graphiques n'aura aucune incidence sur la qualité l'affichage des couleurs de nos photos dans Photoshop |

| |

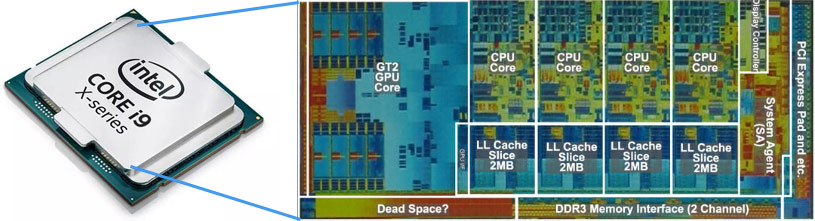

Depuis quelques années - depuis qu'INTEL et AMD, fabricants de processeurs, ont plus de mal à doubler leurs puissances de calculs bruts tout les 18 mois donc selon la fameuse loi de Moore -, les fabricants de processeurs ont eu l'idée non plus de chercher à augmenter uniquement leur puissance mais de multiplier le nombre d'unités de calculs à l'intérieur d'un même CPU : on appelle cela les cœurs (ou Cores). |

| |

|

|

| |

| |

|

| |

| |

|

| |

| |

|

| |

| |

Préambule ! Je trouve que de plus en plus d'écrans, calibrés avec les dernières sondes X-Rite ou Datacolor, offrent des dégradés beaucoup plus propres, même sur des écrans "entrée de gamme" comme mon Dell P2421 ou l'Asus PA248QV et pourtant avec des cartes graphiques "normales" et sans calibrage hardware, censé être la crème de la crème ! Les progrès matériels vont donc dans le bon sens... Préambule ! Je trouve que de plus en plus d'écrans, calibrés avec les dernières sondes X-Rite ou Datacolor, offrent des dégradés beaucoup plus propres, même sur des écrans "entrée de gamme" comme mon Dell P2421 ou l'Asus PA248QV et pourtant avec des cartes graphiques "normales" et sans calibrage hardware, censé être la crème de la crème ! Les progrès matériels vont donc dans le bon sens...

Commençons par les bits des images : 8 ou 16 bits ?

Comme nous l'avons vu sur la page consacrée à l'œil humain et les couleurs, un œil humain doué d'une très belle acuité visuelle est capable de distinguer deux cents nuances pour chaque couleur primaire RVB. Comme notre vue est basée sur un modèle de mélange RVB cela nous donne huit millions de possibilités donc de couleurs, le fameux espace couleur L*a*b*. Ainsi, pour afficher ces couleurs, nous avons besoin d'un modèle informatique basé sur l'octet (huit bits) car cela permet 256 valeurs par couleur primaire. (Avec sept bits nous n'aurions eu que 128 possibilités). Nous nous retrouvons donc avec seize millions de combinaisons possibles alors que nous ne voyons que huit millions de couleurs au maximum ! Pour être affichée correctement, une image n'a donc absolument pas besoin d'être en 16 bits. 8 bits suffisent largement. Mais alors à quoi servent les images 16 bits ? Et bien uniquement pendant la phase de retouche. Chaque couleur primaire étant alors décrite sur 65536 niveaux, les conversion de profil ICC à espace couleur, d'espace couleur à espace couleur, les niveaux et autres saturations se feront avec un tel niveau de précisions que les pertes seront largement minimisées (On dit que cela évite les erreurs d'arrondis).

Point clef ! Une image pour être affichée correctement n'a pas besoin d'être en 16 bits. 8 bits suffisent. En revanche, les risques de dégradations seront largement réduits sur une images en 16 bits lors des différentes retouches (quand on resserre les seuils de manière importante plusieurs fois de suite par exemple). La qualité d'affichage d'un dégradé même en 8 bits peut donc être parfaite. C'est ailleurs que la qualité d'affichage se joue... Point clef ! Une image pour être affichée correctement n'a pas besoin d'être en 16 bits. 8 bits suffisent. En revanche, les risques de dégradations seront largement réduits sur une images en 16 bits lors des différentes retouches (quand on resserre les seuils de manière importante plusieurs fois de suite par exemple). La qualité d'affichage d'un dégradé même en 8 bits peut donc être parfaite. C'est ailleurs que la qualité d'affichage se joue...

8, 10, 14 ou 16 bits... pour la table LUT de l'écran ?

Les tables LUT (tables de conversion du signal reçu - celui de l'image - vers le signal envoyé à l'écran) des écrans peuvent donc être en 8, 14 ou même 16 bits. Mais pour quoi faire ? Tout est une question d'erreurs d'arrondis pendant les conversions ! Voyons cela maintenant...

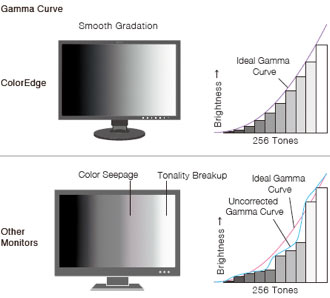

Vocabulaire pour comprendre - Un peu de technique pour commencer : un signal RVB de votre photo doit être envoyé à votre carte graphique puis à votre écran pour être affiché correctement, si possible sans perte. Or il peut subir une dégradation lors de sa transmission de l'un à l'autre. Le passage de témoin du signal original (celui de votre fichier numérique), se fait dans ce que l'on appelle une table LUT. Il existe une table LUT dans votre carte graphique et une autre dans votre écran. LUT est un acronyme anglais qui veut dire en un mot table de conversion. Or le problème est très simple : quand un signal RVB de votre fichier est envoyé à un autre périphérique - ici vers votre carte graphique puis vers votre écran - et comme on travaille en numérique donc en bit et non en continu (on travaille sur 256 niveaux), il peut y avoir des approximations dans le passage de témoins pendant ce que l'on appelle la conversion. Le fichier source possède une valeur RVB donnée et cette valeur RVB doit être légèrement modifiée par l'appareil de destination (pour différentes raisons que j'explique sur ma page dédiée à la conversion). C'est lors de ce calcul de conversion qui peut y avoir des erreurs d'approximation que l'on appelle aussi des erreurs d'arrondis et qui vont se matérialiser par... ces fameuses cassures de tons. Notre fichier source contient un beau dégradé de bleu du ciel et il apparaît pourtant avec des cassures de tons sur l'écran... Vocabulaire pour comprendre - Un peu de technique pour commencer : un signal RVB de votre photo doit être envoyé à votre carte graphique puis à votre écran pour être affiché correctement, si possible sans perte. Or il peut subir une dégradation lors de sa transmission de l'un à l'autre. Le passage de témoin du signal original (celui de votre fichier numérique), se fait dans ce que l'on appelle une table LUT. Il existe une table LUT dans votre carte graphique et une autre dans votre écran. LUT est un acronyme anglais qui veut dire en un mot table de conversion. Or le problème est très simple : quand un signal RVB de votre fichier est envoyé à un autre périphérique - ici vers votre carte graphique puis vers votre écran - et comme on travaille en numérique donc en bit et non en continu (on travaille sur 256 niveaux), il peut y avoir des approximations dans le passage de témoins pendant ce que l'on appelle la conversion. Le fichier source possède une valeur RVB donnée et cette valeur RVB doit être légèrement modifiée par l'appareil de destination (pour différentes raisons que j'explique sur ma page dédiée à la conversion). C'est lors de ce calcul de conversion qui peut y avoir des erreurs d'approximation que l'on appelle aussi des erreurs d'arrondis et qui vont se matérialiser par... ces fameuses cassures de tons. Notre fichier source contient un beau dégradé de bleu du ciel et il apparaît pourtant avec des cassures de tons sur l'écran...

Point clef ! Notez que l'on parle bien de beaux fichiers images et pas d'images sur-traitées donc forcément pleines de cassures de tons réelles, elles, et qui n'ont donc aucune raison de ne pas apparaître comme telles sur l'écran ! On parle bien de ne pas ajouter des cassures à un fichier qui n'en contenait pas. Point clef ! Notez que l'on parle bien de beaux fichiers images et pas d'images sur-traitées donc forcément pleines de cassures de tons réelles, elles, et qui n'ont donc aucune raison de ne pas apparaître comme telles sur l'écran ! On parle bien de ne pas ajouter des cassures à un fichier qui n'en contenait pas.

Pour éviter cela au maximum, les fabricants installent donc des tables LUT dans leurs écrans qui travaillent en 10 bits (ou plus) et non en 8 bits classiquement donc sur 1024 niveaux au lieu de 256 afin de "lisser" ces pertes. Mais comme le marketing passe par là et que les tables LUT en 10 bits existent depuis plus de cinq ans, on parle maintenant de tables LUT en 16 bits. Et pourquoi pas en 32 bits aussi !!! L'objectif étant juste de rendre minuscule l'erreur d'arrondi, cet objectif peut déjà être atteint en 10 bits et à fortiori en 14 bits donc le 16 bits est "presque" un argument marketing à part pour l'écran Eizo CG319X.

Mon avis - Effectivement, les écrans avec table LUT sur 10 bits et plus affichent toujours des dégradés très progressifs à partir de fichiers "propres" (avec des photos sous exposées et trop éclaircies, vous aurez des cassures de tons même sur ces configurations matérielles de luxe). Cependant, les dégradés d'un iMac récent sont très beaux également et pourtant en 8 bits ! Quant aux tables LUT écran à plus de 10 bits, vous savez maintenant ce que j'en pense... Un affichage en 10 bits est toujours bon car synonyme de volonté de qualité de la part du fabriquant mais on peut trouver du très beau également en 8 bits. Le 10 bits est une amélioration à la marge donc ne vous attendez jamais à quelque chose de spectaculaire tout le temps. Il faut souvent se rapprocher de l'écran tant les erreurs de conversions sont faibles quand on travaille sur des beaux fichiers et sur des écrans récents correctement calibrés. Mon avis - Effectivement, les écrans avec table LUT sur 10 bits et plus affichent toujours des dégradés très progressifs à partir de fichiers "propres" (avec des photos sous exposées et trop éclaircies, vous aurez des cassures de tons même sur ces configurations matérielles de luxe). Cependant, les dégradés d'un iMac récent sont très beaux également et pourtant en 8 bits ! Quant aux tables LUT écran à plus de 10 bits, vous savez maintenant ce que j'en pense... Un affichage en 10 bits est toujours bon car synonyme de volonté de qualité de la part du fabriquant mais on peut trouver du très beau également en 8 bits. Le 10 bits est une amélioration à la marge donc ne vous attendez jamais à quelque chose de spectaculaire tout le temps. Il faut souvent se rapprocher de l'écran tant les erreurs de conversions sont faibles quand on travaille sur des beaux fichiers et sur des écrans récents correctement calibrés.

Et enfin l'affichage 10 bits des cartes graphiques ?

Cela méritait bien une page spécifique : |

|

| |

Qu'est-ce que le calibrage hardware ?

Pour bénéficier d'un calibrage hardware, vous aurez besoin :

- d'un écran compatible,

- d'un câble USB dédié (à moins d'utiliser un câble USB-C),

- d'un logiciel de calibrage compatible (comme ColorNavigator ou Palette Master Element).

Le calibrage d'un écran se fait toujours en deux étapes : l'étalonnage puis la caractérisation, processus pendant lequel est vraiment créé le profil ICC. D'habitude, lors de l'étalonnage, vous choisissez des valeurs cibles (luminosité, illuminant D65 ou D50, contraste, etc.) dans le logiciel puis vous placerez votre colorimètre sur l'écran afin qu'il vous aide à atteindre ces valeurs. Pour cela, vous avez à votre disposition les touches et les menus OSD de l'écran. En suivant les instructions qui s'affichent à l'écran vous savez s'il vous faut baisser ou augmenter la luminosité de votre écran avec les touches dédiées. Quand l'écran est bien réglé - bien étalonné - alors seulement, le logiciel fait défiler les plages colorées pour caractériser celui-ci. Le calibrage d'un écran se fait toujours en deux étapes : l'étalonnage puis la caractérisation, processus pendant lequel est vraiment créé le profil ICC. D'habitude, lors de l'étalonnage, vous choisissez des valeurs cibles (luminosité, illuminant D65 ou D50, contraste, etc.) dans le logiciel puis vous placerez votre colorimètre sur l'écran afin qu'il vous aide à atteindre ces valeurs. Pour cela, vous avez à votre disposition les touches et les menus OSD de l'écran. En suivant les instructions qui s'affichent à l'écran vous savez s'il vous faut baisser ou augmenter la luminosité de votre écran avec les touches dédiées. Quand l'écran est bien réglé - bien étalonné - alors seulement, le logiciel fait défiler les plages colorées pour caractériser celui-ci.

Avec certains écrans haut de gamme et certains logiciels de calibrage comme ColorNavigator (Eizo), ou Palette Master Element (BenQ), la partie étalonnage peut être prise en charge automatiquement, sans que vous ayez à intervenir vous-même sur l'écran. Vous définissez des valeurs cibles à atteindre dans le logiciel et il va faire directement les modifications dans la table LUT de l'écran à votre place. Cela offre au moins deux avantages : un qualitatif et un pratique. Qualitatif tout d'abord car le calibrage hardware est censé permettre d'afficher des courbes de corrections plus régulières donc des dégradés sans cassures de tons. J'avais cette possibilité sur mon ancien Quato et j'ai cette possibilité sur mon actuel Eizo CS240 et franchement, je ne vois pas la différence avec/sans (toujours à partir de beaux dégradés en 16 bits). Sur le papier c'est mieux mais dans les faits, sur les très bons écrans et en aveugle, on ne voit pas forcément la différence... Pratique maintenant : le deuxième avantage reste la possibilité d'injecter directement le profil ICC dans la table LUT de l'écran et non uniquement l'installer dans le dossier des profils ICC de votre ordinateur. Mais à quoi cela peut-il bien servir ? Simplement à désolidariser l'ordinateur qui sert au calibrage de l'écran de ce dernier, dans une entreprise par exemple. Imaginez que le responsable du parc d'écrans de la dite société doive calibrer tous les écrans, avec un calibrage "classique", il devrait installer le logiciel de calibrage sur tous les postes de travail alors qu'avec un calibrage hardware il n'aura besoin de l'installer que sur son poste de travail... donc une seule fois. Ensuite, il calibrera tous les écrans depuis son bureau et pourra les rendre à tous les salariés parfaitement calibrés.

Les questions à se poser avant d'acheter un écran photo et/ou vidéo - Pages suivantes :

10 / 10 - Accessoires et nettoyage de son écran - Bientôt

|

|

| |

|

|

|

|